Deep Reinforcement Learning für die Produktionsplanung

Ausgangslage

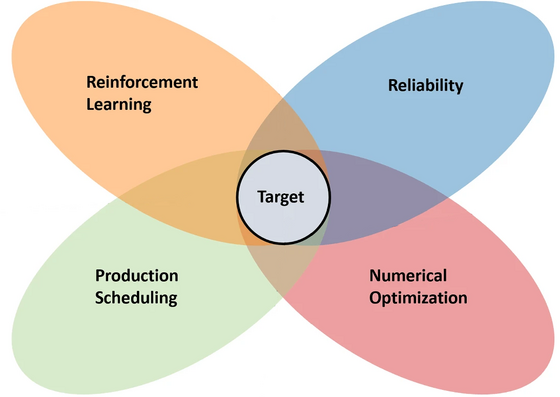

Die Produktionsplanung ist ein Forschungsgebiet, das durch rechnerisch komplexe kombinatorische Planungsprobleme gekennzeichnet ist. Sie umfasst Methoden zur Lösung von Aufgaben, bei denen verfügbare Ressourcen effizient auf Produktionsprozesse verteilt werden müssen. Mit zunehmender Produktvielfalt und kürzeren Produktions- und Innovationszyklen steigen die Komplexität der Probleme und die Anforderungen an die Planungsmethoden. Einerseits müssen Produktionspläne eine robuste und qualitätsbewusste Produktion ermöglichen und KPIs wie Durchlaufzeiten und Ressourcenverbrauch erfüllen. Andererseits muss die Planung mit abrupten Änderungen der Produktionsbedingungen wie Ressourcenengpässen oder Maschinenausfällen umgehen können. Ein vielversprechender Weg, diese Anforderungen zu erfüllen, ist maschinelles Lernen, insbesondere Deep Reinforcement Learning (DRL). In unserer Forschung untersuchen wir den Einsatz von DRL zur Lösung sowohl standardisierter Planungsprobleme aus der Forschung als auch realer Planungsprobleme aus der Industrie.

DRL für Job Shop Scheduling

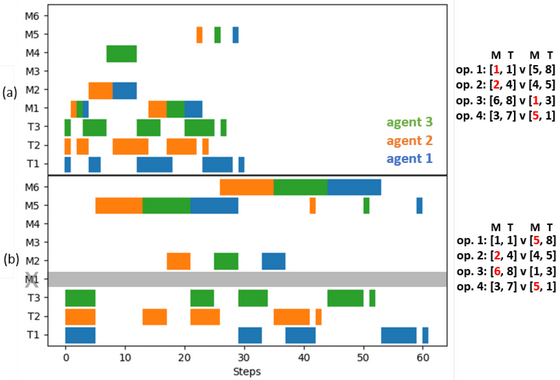

Ein zentrales Planungsproblem, das wir adressieren, ist das Job Shop Scheduling Problem (JSSP), bei dem Aufträge auf einer definierten Anzahl von Maschinen bearbeitet werden, wobei jeder Auftrag die Maschinen in einer anderen vordefinierten Reihenfolge besucht. In diesem Zusammenhang untersuchen wir Multi-Agenten-Ansätze zur Erhöhung der Flexibilität hinsichtlich verschiedener JSSP-Größen (z.B. Anzahl der zu verteilenden Maschinen) oder verschiedener Belohnungsfunktionen und Handlungsräume, die zur Verbesserung von Standard-DRL-Trainingsverfahren eingesetzt werden können. Darüber hinaus untersuchen wir Variationen des Problems, wie z.B. flexible JSSPs, bei denen nicht nur die optimale Reihenfolge der Operationen bestimmt werden muss, sondern auch zwischen verschiedenen Maschinen gewählt werden kann, die eine Operation ausführen können. Der Schwerpunkt unserer Forschung liegt auf der adäquaten Reaktion auf unvorhergesehene Ereignisse, wie z.B. das Eintreffen neuer Aufträge in der Produktion.

Schlably Framework

Ein wichtiger Meilenstein unserer täglichen Forschung ist die Entwicklung und Veröffentlichung des Python-basierten Software-Frameworks schlably für DRL-basierte JSSP (Dokumentation unter Read the Docs). Mit schlably können empirische Experimente mit kundenspezifischen Lösungsansätzen entwickelt, durchgeführt, ausgewertet und mit bestehenden Benchmarks verglichen werden.

Einsatz für Reale Planungsszenarien

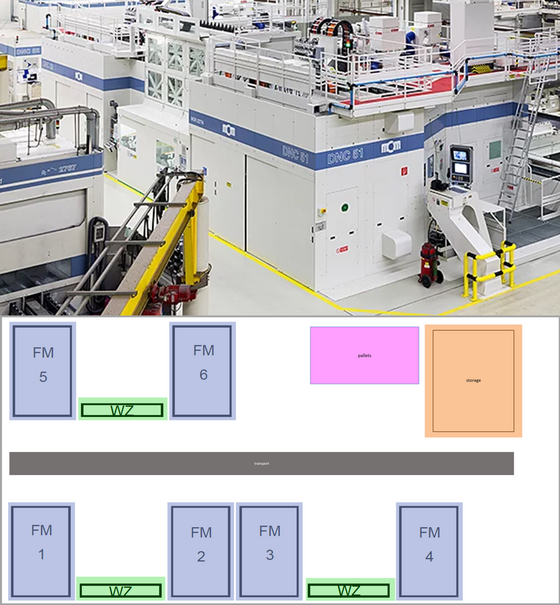

In unserer Forschung untersuchen wir den Einsatz der Verfahren in realen Anwendungsfällen zur Steuerung und Planung von Produktionsprozessketten in digitalisierten Shopfloors. Wesentliche Forschungsziele sind die Schaffung einer Datenbasis durch Erfassung, Vorverarbeitung und Bereitstellung prozesskettenrelevanter Daten sowie die Entwicklung und Erprobung von KI-basierten Planungs- und Steuerungssystemen, die bei Störungen und daraus resultierenden Abweichungen vom geplanten Prozessablauf geeignete Reaktionsstrategien vorschlagen, um die zuvor identifizierten Planungsziele einzuhalten.

Publikationen zum Thema

- 2023

- Waubert-de-Puiseau, C. , Tercan, H. , & Meisen, T. (2023). "Curriculum Learning in Job Shop Scheduling using Reinforcement Learning" .

- Waubert-de-Puiseau, C. , Peters, J. , Dörpelkus, C. , Tercan, H. , & Meisen, T. (2023). "schlably: A Python Framework for Deep Reinforcement Learning Based Scheduling Experiments" , arXiv arXiv:2301.04182 .

- 2022

- Waubert-de-Puiseau, C. , Nanfack, D. T. , Tercan, H. , Löbbert-Plattfaut, J. , & Meisen, T. (2022). "Dynamic Storage Location Assignment in Warehouses Using Deep Reinforcement Learning" , Technologies , 10 (6), 129.

- Waubert-de-Puiseau, C. , Meyes, R. , & Meisen, T. (2022). "On reliability of reinforcement learning based production scheduling systems: a comparative survey" , Journal of Intelligent Manufacturing , 33 (4), 911--927.